打开微信,使用扫一扫进入页面后,点击右上角菜单,

点击“发送给朋友”或“分享到朋友圈”完成分享

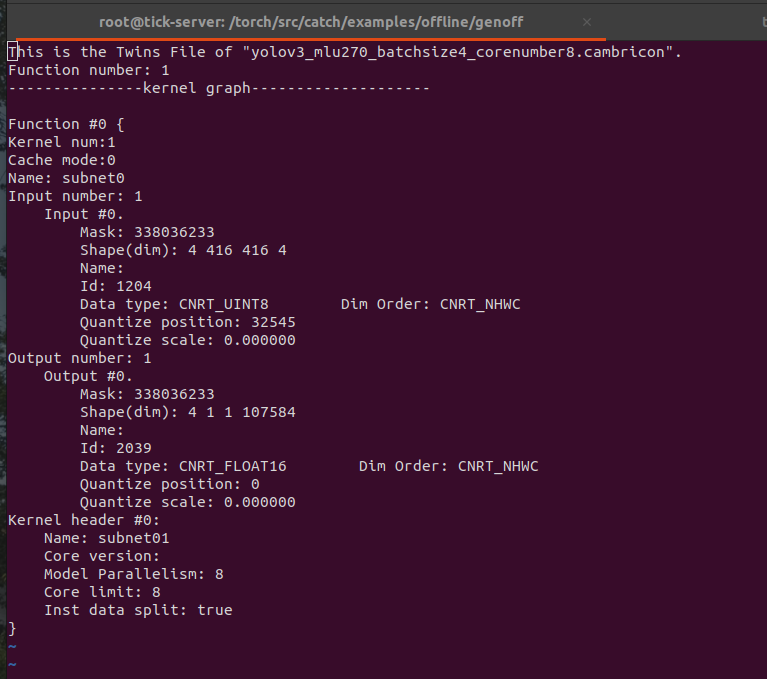

我利用cnrt接口实现了离线模型的推理,现在想支持batch功能,请问是使用 cnrtInvokeRuntimeContext_V3 接口吗? 其中batch_size

// Run batch : 1, 3, 4, 5

// Cache model: 1, 3, 4 should be success, others should be failed.

// Non-cache model: 4, null should be success, others should be failed.

int batch_sizes[4][1] = {{1}, {3}, {4}, {5}};按照模型是否为Cache mode 有两种不同的输入格式,这个是模型的Cache model吗? 在生成离线模型时怎么指定是不是Cache mode

热门帖子

精华帖子