打开微信,使用扫一扫进入页面后,点击右上角菜单,

点击“发送给朋友”或“分享到朋友圈”完成分享

在寒武纪mlu270平台上生成yolov5模型离线文件,先进行int8量化后,后逐层或者融合,输出的目标框变得不准,目标框变大,且出现很多重复的框,若有碰到类似问题,有劳各位才能知士帮忙解答。

量化主要代码:

global quantized_model

if opt.cfg == 'qua':

qconfig = {'iteration':2,'firstconv':False}

quantized_model = mlu_quantize.quantize_dynamic_mlu(model, qconfig, dtype='int8', gen_quant=True)

...

if opt.cfg == 'qua':

pred = quantized_model(img)[0]

torch.save(quantized_model.state_dict(), 'yolov5s_int8.pt')

本人的提出问题:

问题1:qconfig量化参数iteration是指需要传入量化图片个数吗,量化方式是一张张传入量化还是全部?

问题2:当训练样本的检测目标尺寸存在较大差异时,in8量化后是否使检测精度下降很多?

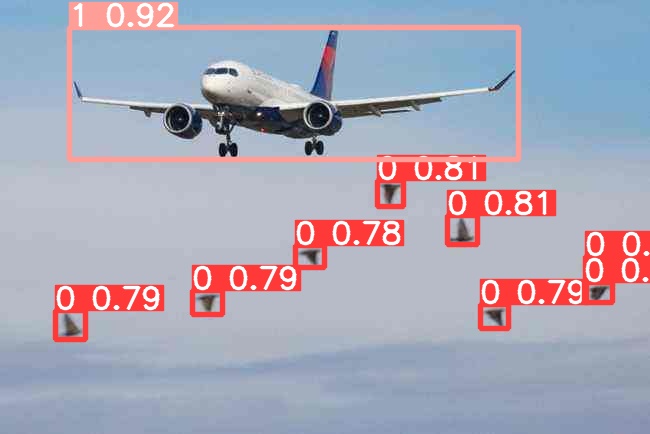

第一张:cpu推理;

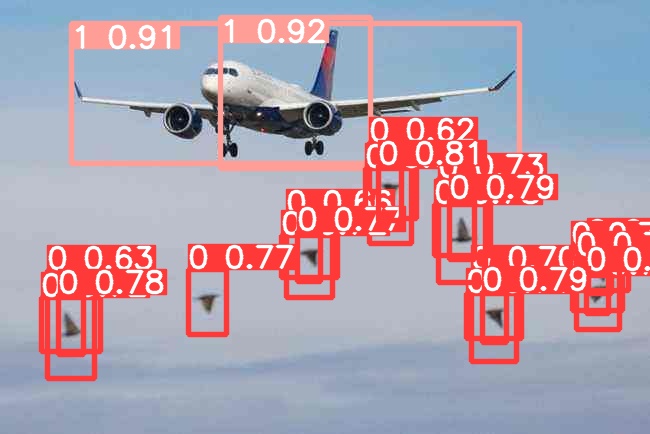

第二张:int8量化后,再逐层或者融合;

以上问题,个人认为原因:训练集的目标尺寸存在较大差异,int8量化后,精度降低很多,应该是int8量化这个过程出来问题,但是具体那里出的问题未知。

热门帖子

精华帖子