打开微信,使用扫一扫进入页面后,点击右上角菜单,

点击“发送给朋友”或“分享到朋友圈”完成分享

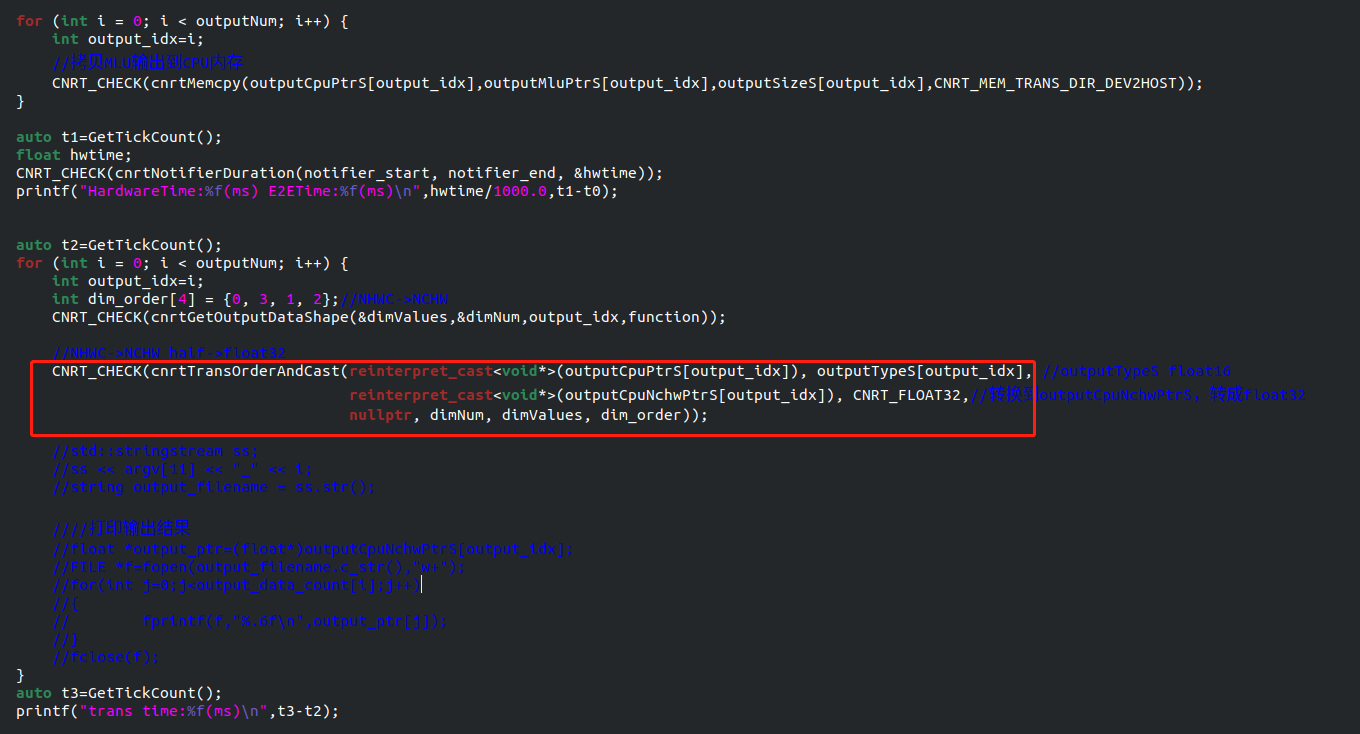

1. MLU220,模型有两个输出,维度分别是248*216*18=964224 ,248*216*42=2249856,模型推理部分耗时100ms左右,cnrtTransOrderAndCast函数将NHWC->NCHW half->float32,该函数耗时达到300ms左右,这个数据量这么耗时吗,是模型推理的3倍。有没有可能优化呢?

2. 后面还要接CPU后处理,有没有可能跳过cnrtTransOrderAndCast函数,直接在后处理函数中取模型输出的NHWC FLOAT16数据(当然这样读取数据比转换成NCHW更复杂),这样应该会有性能提升?

热门帖子

精华帖子